页面未被索引?解决谷歌错误 2026

专家评审

如果您发现 Google Search Console (GSC) 中大量页面未被索引,您并非个例。2026 年,索引机制的设计更加注重选择性:Google 愿意发现的网址数量远多于长期保留在索引中的网址数量。其目标并非强行将所有内容都纳入索引,而是确保对您的业务至关重要的网址可以被抓取、渲染,并且显然值得索引。

2026 年谷歌索引的运作方式(以及为何变得更加严格)

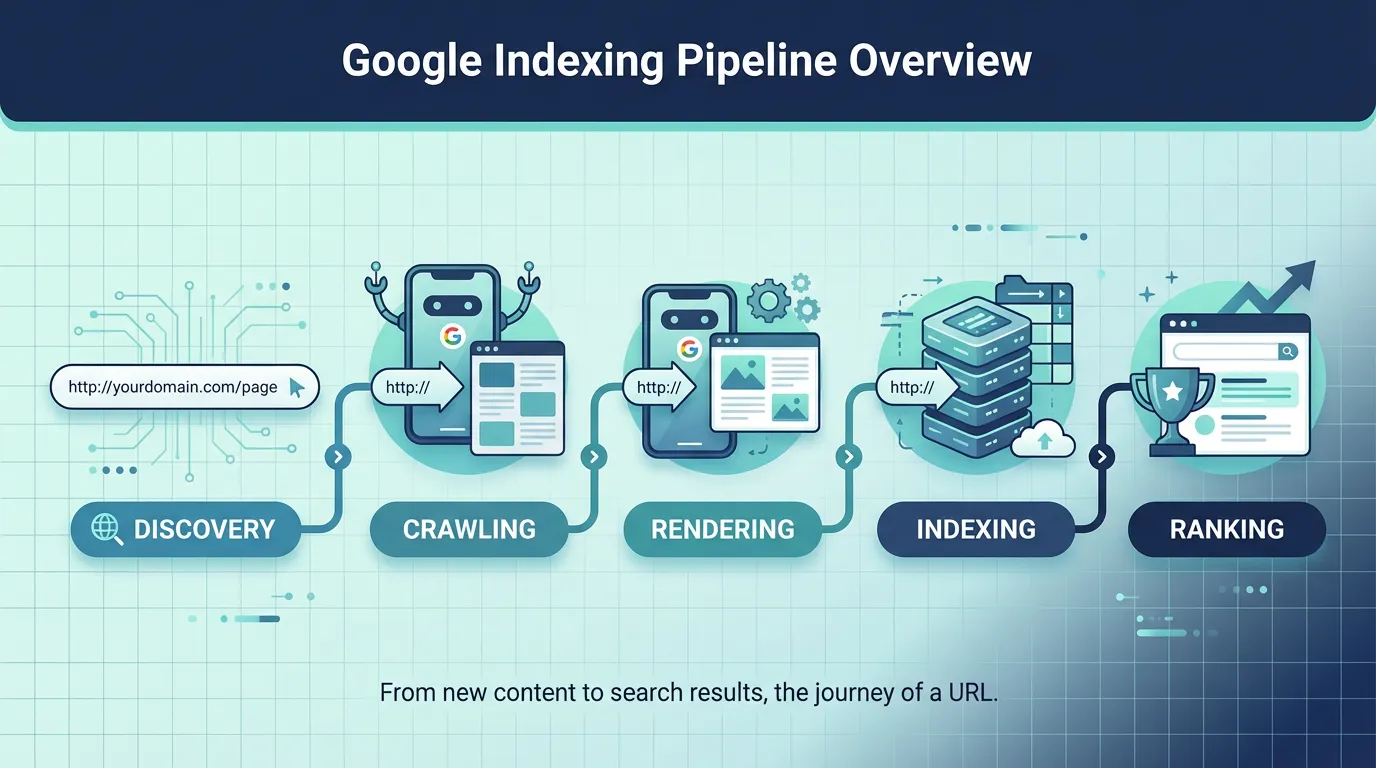

谷歌通常会按照一定的流程处理网址:发现、抓取、渲染,然后索引。2024 年至 2026 年的关键变化并非谷歌无法索引你的网页,而是它经常选择不索引。

值得略读的权威参考资料:

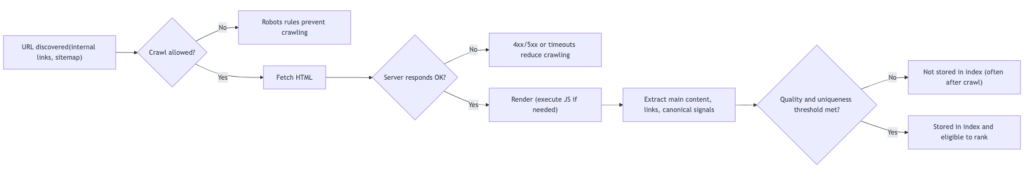

以下是能够解释大多数现实案例的简化决策路径:

对营销人员和开发人员而言,有两点实际意义:

- 索引问题通常是更深层次问题的征兆(网站架构、重复数据、模板薄弱、性能或 JavaScript 渲染)。

- GSC标签并不一定意味着危机。只有当它影响到营收页面(产品、类别、潜在客户开发着陆页、关键国际页面)时,才会变得紧急。

如何不慌张地阅读页面索引报告

当利益相关者看到“未收录”字样时,他们通常会认为会受到处罚。但实际上,该报告会综合考虑以下因素:

- 正常除外情况(有意或无意),以及

- 严重故障(重要 URL 的配置错误或信号质量低下)。

使用此表作为从 GSC 语言到业务行动的初步翻译工具:

| GSC 状态(常见) | 用通俗易懂的英语来说,它通常的意思是什么? | 何时该担心 | 首先要采取的行动 |

|---|---|---|---|

| 已发现状态 | 谷歌知道该网址存在,但正在延迟抓取。 | 如果该网址对业务至关重要,并且连续 4 到 6 周无法访问 | 优化内部链接,清理站点地图,检查爬虫统计数据和服务器速度 |

| 已爬取状态 | 谷歌已获取该数据,但选择不将其存储在索引中。 | 如果是转化页面或核心着陆页 | 升级内容,修复重复项和规范信号,验证渲染效果 |

| 重复/规范相关 | 谷歌更倾向于使用另一个网址作为主版本 | 如果您的首选 URL 未被索引 | 对齐规范链接、内部链接和站点地图条目 |

| 软性 404 | 页面返回200,但页面显示为空或“未找到”。 | 如果重要的旧版网址或产品受到影响 | 返回正确的 404/410 错误,或添加有意义的内容和替代方案。 |

| 被机器人规则屏蔽 | 谷歌无权抓取它 | 如果这是一个用于排名的部分。 | 缩小搜索范围,并确保关键资源(CSS/JS)可被抓取。 |

| 已排除 noindex | 你(或某个模板)告诉谷歌不要索引 | 如果它蔓延到重要的模板中 | 审计模板和标头,以发现意外的 noindex 错误 |

有关官方定义以及 Google 在哪里显示这些状态,请参阅:Google 提供的页面索引报告帮助。

使用单个工作流程修复“已发现”和“已爬取”状态(已优先处理)

大多数团队失败的原因在于他们使用清单式的检查,而没有进行优先级排序。请改用以下工作流程:首先确定业务重要性,然后诊断谷歌延迟或拒绝的原因。

第一步:将关键URL与“索引噪声”区分开来

创建一份简短的 URL 类型列表,并按其对业务的影响程度进行排名:

- 关键页面:类别页面、带来收入的产品页面、潜在客户开发页面、核心国家/语言页面。

- Medium:常青博客中心、解决方案解释、比较页面。

- 低:内部搜索结果、大多数筛选组合、重复标签存档、跟踪参数。

如果你运营的是电商网站或以产品目录为主的导出网站,那么拥有许多低价值的URL是很正常的,这些URL不应该被搜索引擎索引。你的任务是防止它们占用搜索引擎的抓取资源。

步骤二:确认实时索引功能(在修改内容之前)

对于任何关键URL:

- 验证是否返回 200(不是重定向链,也不是损坏的 5xx)。

- 确认它没有被机器人规则屏蔽。

- 确认没有 noindex 元标签或标头。

- 验证 Googlebot 是否能在页面依赖 JavaScript 的情况下渲染有意义的主要内容。

如果您的网站大量使用 JavaScript,请对照 Google 的移动抓取实际情况进行检查:移动优先索引最佳实践。

步骤 3:如果状态为“已发现”,则提高优先级信号

这通常是一个预算和优先级排序问题:

- 加强内部联系:

- 来自类别中心、导航和相关编辑指南的链接。

- 避免创建孤立页面和“仅在站点地图中显示”的页面。

- 优化您的 XML 站点地图策略:

- 尽可能只包含规范的、可索引的、高优先级的 URL。

- 从站点地图中删除参数化 URL 和近似重复项。

- 降低爬行噪音:

- 取消低价值过滤器组合的关联。

- 考虑屏蔽真正无用的网址模式,以便谷歌将时间花在真正重要的事情上。

- 稳定服务器性能:

- 响应缓慢和错误频发会导致谷歌减少抓取次数。

- 对于亚太地区的用户来说,这种情况尤其常见,因为托管和 CDN 路由不具备区域感知能力。

经验法则:如果关键页面超过 4 到 6 周仍无法访问,则应将其视为系统架构/性能问题,而不是单个 URL 问题。

步骤 4:如果状态为“已抓取”,则将其视为质量问题、重复问题或渲染问题。

这是“谷歌查看后决定不解决”的情况。以下是一些真正有效的常见解决方法:

- 合并近似重复项:

- 对于产品变体,确定哪个页面应该代表该集群。

- 将规范标签、内部链接和站点地图条目围绕该首选页面对齐。

- 提升页面价值(尤其适用于 B2B 和出口商):

- 添加真正的差异化因素:用例、规格、常见问题解答、比较表、合规性详情、运输/交货时间或区域可用性。

- 请确保内容不是替换了关键词的模板化样板代码。

- 修复渲染间隙:

- 如果由于内容加载延迟或失败导致渲染视图内容较少,Google 可能会将其视为低价值内容。

- 确保 Googlebot 渲染时,必要的文本和内部链接都能可靠地存在。

一项为期 30 至 90 天的计划,旨在减少索引问题而不浪费精力。

索引改进通常需要迭代。这种分阶段的计划能让团队专注于影响增长的因素,同时降低对无害内容的排除优先级。

阶段使用方法如下:

- 第 0 至 30 天:首先修复全局错误(机器人规则、意外的 noindex、站点地图污染、长期存在的 5xx 错误)。

- 第 31 至 60 天:重建优先页面的内部链接,合并重复项,纠正规范不一致。

- 第 61 至 90 天:升级关键被拒绝页面的内容,然后处理 JavaScript 渲染和核心 Web 指标改进。

为了避免徒劳无功,请密切关注已知的报告延迟情况。相关背景信息,请参阅:Search Engine Land 对页面索引报告延迟的报道。

何时引入SeekLab.io(以及需要提出哪些要求)

有些索引问题很简单,而另一些则是系统性问题,尤其对于以下情况:

- 具有分面导航的大型目录

- 多语言或多区域网站(亚太地区、美国、欧盟)

- JavaScript 框架中渲染的内容与原始 HTML 不同。

SeekLab.io专注于诊断真正影响增长的因素,以及可以安全地降低优先级的因素。除了全站抓取和结构化分析之外,团队通常还需要关于内部链接策略、站点地图和 robots.txt 验证、渲染检查、核心 Web 指标诊断、模式合规性以及内容规划的明确指导,这些内容规划能够在不造成索引膨胀的情况下提高主题覆盖率。

如果您需要第二组专家的帮助:

- 获取免费审核报告:分享您的域名以及影响关键 URL 的具体 GSC 状态。

- 联系我们:告诉我们哪些市场比较重要(美国、欧洲、亚太地区),以及哪些页面类型能够带来潜在客户或收入。

- 请留下您的网站域名:我们可以快速确认您遇到的问题是配置错误、抓取优先级设置还是质量阈值。

快速常见问题解答

在发现状态后应该等待多久才开始担心?

如果该 URL 很重要,并且持续超过 4 到 6 周未更新,则应调查内部链接、站点地图质量、抓取统计数据和服务器性能。

是否应该为每个 URL 都请求索引?

不应该。只有在关键 URL 的信号得到改善后才应请求索引。对低价值页面进行索引请求通常会浪费时间,并且可能掩盖真正的问题(低价值 URL 过多)。

如果很多筛选页面没有被索引,这算坏事吗?

通常来说,这反而是好事。这样做的目的是为了保证用户能够正常使用筛选功能,同时防止URL无限制增长而占用抓取资源。

为什么有些页面即使被 Google Search Console 标记为未编入索引,仍然会出现在 Google 搜索结果中?

这是因为报告可能存在延迟,规范网址的选择可能因网址变体而异,而且 Google 可能会显示某个规范网址,同时排除其他备选网址。务必使用网址检查和规范信号进行验证。

如果您分享您的域名和您最关心的前 20 个 URL,通常可以在一次审查周期内找出真正的瓶颈。